L’algorithme, l’instrument du fascisme 2.0

L’algorithme est il totalitaire ? Très belle démonstration du piège de l’I.A. (Intelligence Artificielle) dans lequel nous sommes entrain de tomber en masse.

Bientôt fini la liberté sur les réseaux sociaux ? Ne serons plus autorisées que les infos utiles aux dominants ?

Cette société et son évolution font froid dans le dos. Orwell, ce n’est plus une fiction. C’est maintenant.

Aimez-vous l’algorithme & blues ?

Par Pepe Escobar – Source Strategic-Culture

Nous vivons tous dans l’âge de l’algorithme.

Alors, voici une histoire qui non seulement est bien dans l’air du temps, mais révèle de façon insistante la façon dont l’obsession de l’algorithme peut finir horriblement mal.

Tout a commencé quand Facebook a censuré la photo iconique de la «fille au napalm» Kim Phuch, qui est devenue un symbole de la guerre du Vietnam reconnu partout dans le monde. La photo figurait dans un message Facebook de l’écrivain norvégien Tom Egeland, qui a voulu lancer un débat sur les «sept photographies qui ont changé l’histoire de la guerre».

Non seulement son post a été effacé, mais Egeland a également été suspendu de Facebook.

Aftenposten, le numéro un des quotidiens norvégiens, détenu par le groupe de médias scandinave Schibsted, a dûment relayé la nouvelle, avec la photo.

Facebook a alors demandé au journal d’effacer la photo – ou de la rendre méconnaissable dans son édition en ligne. Pourtant, sans même attendre la réponse, Facebook a censuré l’article, ainsi que la photo, sur la page Facebook du journal Aftenposten.

Le Premier ministre norvégien Erna Solberg a protesté contre tout cela sur sa page Facebook. Elle a également été censurée.

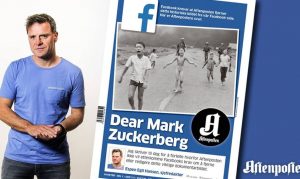

Aftenposten a alors collé toute l’histoire en première page, à côté d’une lettre ouverte au fondateur de Facebook, Mark Zuckerberg, signée par le directeur du journal, Espen Egil Hansen, accusant Facebook d’abus de pouvoir.

Il a fallu attendre de longues heures – 24 heures – pour que le moghol de Palo Alto recule et débloque la publication.

Une opinion enveloppé dans du code [informatique]

Facebook a dû s’engager dans une grande campagne de limitation des dégâts. Cela ne change pas le fait que l’imbroglio de la «fille au napalm» est un drame classique de l’algorithme, comme dans l’application de l’intelligence artificielle pour évaluer les contenus.

Facebook, tout comme les autres géants de l’économie des données [Big Data], en est arrivé à délocaliser le filtrage à une armée de modérateurs travaillant dans des entreprises disséminées du Moyen-Orient à l’Asie du Sud, comme Monika Bickert, de Facebook, l’a confirmé.

Ces modérateurs peuvent prendre la décision d’établir ce qui devrait être radié du réseau social, selon ce que les clients peuvent signaler. Mais l’information est ensuite traitée par un algorithme, qui donne la décision finale.

Il n’y a pas besoin d’être sorti de Polytechnique pour comprendre que ces modérateurs n’excellent pas vraiment dans le domaine culturel, ou sont capables d’analyser le contexte. Sans parler des algorithmes – qui sont incapables de comprendre le contexte culturel et ne sont certainement pas programmés pour interpréter l’ironie, le sarcasme ou les métaphores culturelles.

Les algorithmes sont littéraux. En un mot, l’algorithme est une opinion enveloppée dans du code.

Et pourtant, nous arrivons maintenant à un stade où une machine décide de ce qui est une nouvelle ou pas. Facebook, par exemple, repose désormais uniquement sur un algorithme pour établir quelles informations positionner dans sa section Trending Topics [sujets les plus consultés, NdT].

Il peut y avoir un côté positif à cette tendance – comme lorsque Facebook, Google et YouTube utilisent des systèmes pour bloquer rapidement des vidéos de Daesh et de la propagande djihadiste similaire. Bientôt eGLYPH sera en vigueur – système similaire à Content ID sur YouTube qui censure les vidéos violant les droits d’auteur en utilisant le hachage. Aux vidéos et audios signalées comme extrémistes sera attribuée une empreinte unique, permettant la suppression automatique de toute nouvelle version et le blocage de tout nouveau chargement.

Et cela nous amène dans un territoire encore plus trouble, le concept d’extrémisme lui-même. Et les effets sur nous tous des systèmes d’auto-censure basés sur la logique algorithmique.

Comment les armes de destruction mathématique règlent notre vie

C’est dans cette perspective qu’un livre comme Armes de destruction mathématique, par Cathy O’Neil (Crown Publishing) devient aussi essentiel que l’air que nous respirons.

O’Neil est une vraie bonne affaire : doctorat en mathématiques à Harvard, ancien professeur au Barnard College, ancienne analyste quantitatif dans un hedge fund avant de se reconvertir dans la science des données, elle est aussi blogueuse pour mathbabe.org.

Les modèles mathématiques sont les moteurs de notre économie numérique. Cela amène O’Neil à formuler ses deux idées critiques – qui peuvent effrayer les légions qui considèrent les machines simplement comme neutres.

1. «Les applications mathématiques utilisées dans l’économie des données [sont] basées sur des choix faits par des êtres humains faillibles.»

2. «Ces modèles mathématiques [sont] opaques, leur fonctionnement est invisible à tous, sauf aux plus grands prêtres dans leur domaine : les mathématiciens et les informaticiens. Leurs verdicts, même faux ou nuisibles, [sont] au-delà des litiges ou des recours. Et ils ont tendance à punir les pauvres et les opprimés dans notre société, tout en rendant les riches plus riches.»

D’où le concept forgé par O’Neil d’Armes de destruction mathématique (ADM) [MAD / fou en anglais en référence à la doctrine autour des armes nucléaires du même nom, NdT] pour comprendre comment les modèles mathématiques destructeurs accélèrent un séisme social.

O’Neil détaille longuement comment les modèles mathématiques destructeurs microgérent maintenant de vastes pans de l’économie réelle, de la publicité au système pénitentiaire, sans parler de l’industrie de la finance – et de toutes les séquelles de la crise sans fin de 2008.

Ces modèles mathématiques sont essentiellement opaques, inexplicables, et ciblent avant tout l’optimisation de la consommation des masses.

La règle d’or ici est, comme ailleurs – quoi d’autre ? – de suivre l’argent. Comme le remarque O’Neil : «Pour les personnes qui utilisent les armes de destruction mathématique, la rétroaction est l’argent. Les systèmes sont conçus pour engloutir un maximum de données et affiner les analyses de façon a voir affluer plus d’argent.»

Les victimes – comme dans les frappes administratives de drones d’Obama – ne sont que des dommages collatéraux.

Le parallèle entre le casino de la finance et le Big Data est inévitable – et c’est l’atout de O’Neil d’avoir travaillé dans ces deux industries. Ceci est quelque chose que j’ai examiné dans un autre article sur l’argent dans la Silicon Valley.

La Silicon Valley suit l’argent. Nous voyons le même rassemblement de talents des universités américaines d’élite – MIT, Stanford, Princeton – la même obsession de faire tout ce qu’il faut pour ratisser le plus d’argent possible, et vite, pour la firme qui les emploie.

Les armes de destruction mathématique favorisent l’efficacité. L’équité n’est qu’un simple concept. Les ordinateurs ne comprennent pas les concepts. Les programmeurs ne savent pas comment coder un concept – comme nous l’avons vu dans l’histoire de la «fille au napalm». Et ils ne savent pas comment ajuster les algorithmes pour tenir compte de l’équité.

Tout ce que nous connaissons est le concept d’«ami» mesuré par les goûts et les connexions sur Facebook. O’Neil résume tout : «Si vous pensez une arme de destruction mathématique comme une usine, l’injustice est la substance noire qui se dégage des cheminées. C’est une émission, mais une émission toxique.»

Aboule le fric, maintenant …/…

Suite de l’article ici

http://lesakerfrancophone.fr/aimez-vous-lalgorithme-blues