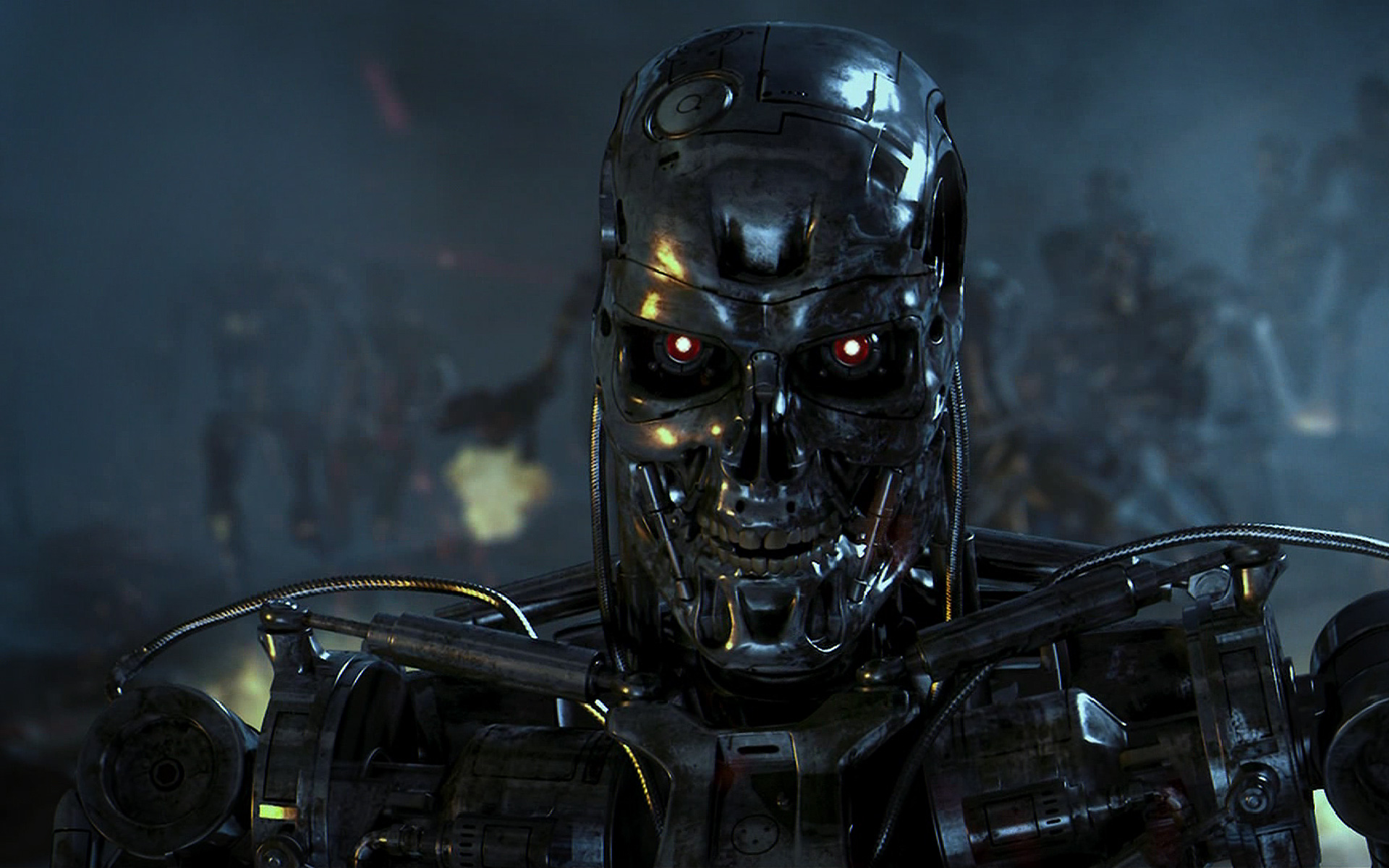

Un Terminator opérationnel d’ici vingt ans : les ONG s’alarment

Terminator n’est plus un personnage de science-fiction : c’est une arme qui pourrait être opérationnelle d’ici vingt ou trente ans. Un « robot tueur » qui n’est pas télécommandé, mais entièrement autonome.

Vous le programmez pour « nettoyer » un immeuble, avec autorisation de tuer tous les êtres humains de plus de 1,30 m s’y trouvant : ensuite, il se débrouille. Ou bien, si c’est un drone, vous l’envoyez au dessus d’un champ de bataille, il détecte tous les véhicules ennemis et les détruit un par un.

Ces armes ne sont pas sans poser des questions éthiques. Lundi, plusieurs ONG et prix Nobel de la paix ont lancé un appel pour une « interdiction préventive » et mondiale des armes autonomes.

Human Rights Watch, International Human Rights Clinic et la Nobel Women’s Initiative ont lancé à Washington une campagne pour alerter l’opinion sur ces robots tueurs alors que des gouvernements ont déjà commencé à en développer.

Les robots n’ont pas d’états d’âme

Le terme « arme pleinement autonome » désigne un robot capable d’exécuter une mission sans aucune intervention humaine. Un tel engin est capable de se mouvoir indépendamment, s’adapter à un terrain et un environnement spécifique et faire usage d’un système létal de manière autonome.

C’est donc un algorithme et non un cerveau humain qui décide de la préservation ou de la destruction d’une cible, éventuellement humaine. Il a un grand avantage pour les militaires : il n’hésite pas à tuer.

Contrairement à ce que l’on voit dans les films de guerre, les militaires ont tendance à éviter, quand ils le peuvent, de tuer. Ils tirent peu, et quand ils le font, ils peuvent mal viser.

La formation des soldats vise justement à casser ce conditionnement pour les rendre capables de tuer. Les robots, eux, ne posent pas ce « problème » aussi vieux que la guerre.

Inquiétude des ONG et de la Croix-Rouge

Le rêve de guerres entre robots et sans perte humaine apparaît aujourd’hui comme une chimère. Le risque est plutôt de multiplier, avec ces armes nouvelles, le nombre de morts. Pour Steve Goose, directeur de la division armes à Human Rights Watch :

« L’exercice par l’homme d’un contrôle sur la guerre robotisée est essentiel pour réduire le nombre des morts et des blessés parmi les civils. »

Il s’inquiète en outre des cas de « violation inévitable des droits de l’homme » et se demande qui en endossera la responsabilité. Sa collègue Bonnie Docherty souligne quant à elle l’absence de compassion d’une machine, les erreurs potentielles dans la distinction entre civils et militaires et dénonce la création d’un « outil parfait pour les dictatures ».

Ces préoccupations ne datent pas d’hier. En 1987, le Comité international de la Croix-Rouge avait déjà fait une déclaration apocalyptique pour alerter l’opinion sur des enjeux soulevés par cette technologie :

« L’usage d’armes de longue distance, à faible niveau de contrôle [humain, ndlr] ou connectées à des capteurs placés sur le terrain mène à une automatisation du champ de bataille où le soldat joue un rôle toujours plus réduit… Toutes les prédictions s’accordent sur le fait que si l’homme ne domine pas la technologie mais la laisse le dominer, il sera détruit par celle-ci. »

Les armes existantes

Le monde où les guerres feraient intervenir des robots autonomes ne serait pas si éloigné, à peine deux ou trois décennies selon le rapport « Losing Humanity » publié lundi par Human Rights Watch.

Des précurseurs de cette nouvelle technologie sont déjà en service. Des armes automatiques défensives sont opérationnelles dans la marine américaine et capables d’intercepter des missiles en plein vol, voire pour les modèles les plus récents de se défendre contre des navires, hélicoptères ou tirs d’artillerie.

Autre illustration d’actualité : le système antibalistique israélien « Iron Dome », capable d’intercepter les roquettes tirées depuis les territoires palestiniens si leur trajectoire venaient à toucher des zones civiles.

La recherche en robotique militaire évolue très rapidement. En témoigne l’avion-drone X-47B commandé par les forces navales américaines qui est capable de décoller et d’atterrir sur un porte-avion ainsi que se ravitailler en vol. Les Britanniques testent de leur côté le Taranis, avion autonome de combat, tandis qu’Israël développe son modèle Harpy également pourvu de capacités létales.

Flou juridique

Au-delà des mises en garde, des polémiques morales et des scénarios de série B, se pose la question de la réglementation juridique de ce nouveau type d’armement.

Qui serait responsable en cas de dysfonctionnement ? Qui, du technicien qui a conçu la machine, du commandant qui a déclenché l’opération ou du fabricant hériterait de la responsabilité légale ?

De plus, les robots tueurs n’appartiennent pas à une classe d’armes identifiée et ne tombent donc sous le coup d’aucune réglementation spécifique, d’où l’appel du pied des ONG pour la négociation d’un traité international.

Une procédure est pourtant prévue pour combler ce type de flou juridique. L’article 36 du Protocole additionnel aux Conventions de Genève du 12 août 1949, ratifié universellement, oblige les Etats à évaluer la compatibilité d’une nouvelle technologie de l’armement avec les principes de droit international et humanitaire auxquels ils sont liés.

Conflit avec le droit humanitaire international

Or le rapport « Losing Humanity » souligne que plusieurs règles de droit international pourraient contrevenir au développement des robots tueurs.

la clause de Martens : la clause de Martens rédigée à la Haye en 1899 interdit l’usage d’armes qui iraient à l’encontre « des usages établis entre nations civilisées, des lois de l’humanité et des exigences de la conscience publique » ;

le principe de distinction : véritable pierre angulaire du droit humanitaire, le principe de distinction élaboré dans l’article 48 du Protocole additionnel établit l’obligation de faire une distinction entre populations civiles et les combattants armés. Une arme ou attaque qui ne parviendrait pas à distinguer les deux parties serait illégale ;

le principe de proportionnalité : l’article 51 du Protocole rappelle que les forces armées doivent faire preuve de mesure dans leurs attaques et ne pas causer « des pertes en vies humaines dans la population civile » qui seraient « excessi[ves] par rapport à l’avantage militaire concret et direct attendu ». On est en mesure de douter qu’une machine puisse réaliser une évaluation pertinente de la proportionnalité d’une attaque ;

le principe de nécessité : notion diffuse qui imprègne le droit international, la nécessité dans le cadre d’une action militaire renvoie à l’obligation de diriger l’usage de la force contre l’ennemi et dans le seul but de gagner la guerre. Toute action qui n’a pas pour but la victoire est prohibée (comprendre tortures, exécutions sommaires…).

Le rapport appelle donc les Etats développant cet armement à respecter leurs obligations, c’est-à-dire « émettre des rapports juridiques détaillés sur toute technologie proposée ou existante qui pourrait conduire à de tels robots ». Ces rapports permettraient, selon l’état d’avancement de la technologie, de mieux établir la compatibilité ou l’incompatibilité de ces robots avec les principes du droit humanitaire.

Les rédacteurs du rapport eux n’ont pas attendu les compte-rendus des Etats pour rendre leurs conclusions sur l’usage des robots tueurs : pour être conformes au droit humanitaire international, les armes pleinement autonomes auraient besoin, selon eux, « de qualités humaines dont elles manquent de façon inhérente ». En particulier, de tels robots « n’auraient pas la capacité de se lier aux autres humains et comprendre leurs intentions ».

de Philippe Vion-Dury

source: http://www.rue89.com/2012/11/23/un-terminator-operationnel-dici-vingt-ans-les-ong-salarment-237239